ìŒì„±ì¸ì‹ì— 필요한 ê¸°ì´ˆê°œë… 1

******************************************************************************************************************************

ì´ ê¸€ì€ ReadyToUseAIì—ì„œ 무료로 ì œê³µí•˜ëŠ” ê°•ì˜ë¥¼ ë“£ê³ ì •ë¦¬í•œ 내용입니다.

ê°•ì˜ë‚´ìš©: ìŒì„±ì¸ì‹ì—ì„œ 딥러ë‹ì€ 어떻게 사용ë 까? (ì‹¬ê·œí™ ê°•ì‚¬ë‹˜)

ìœ íŠœë¸Œ ê°•ì˜ë§í¬ : www.youtube.com/channel/UCpWrFUlwUGZSHVlOT1eD-Wg

오픈채팅방 : open.kakao.com/o/g46ZM7Zc (참여코드 : aiai)

수업 ê´€ë ¨ ìžë£Œ : drive.google.com/drive/folders/1Sd-dQd_b-aKdBLAUQ5jz6lwFmiaTFQ02?usp=sharing

******************************************************************************************************************************

최근 ìžì—°ì–´ì²˜ë¦¬ì™€ ìŒì„±ì¸ì‹ì— ê´€ì‹¬ì´ ìƒê²¨ 공부를 시작하면서 ìœ ìµí•œ ê³³(?)ì„ ë°œê²¬í•´ 해당 ê°•ì˜ë¥¼ ë² ì´ìŠ¤ë¡œ ì •ë¦¬ + 공부한 ë‚´ìš©ì„ ë‚¨ê¸´ë‹¤.

목표는 Speeech-To-Text (STT, ASR) 사ì´ë“œ 프로ì 트 !!!

AIì—ì„œ Speech 분야는 í¬ê²Œ ë‘가지로 나뉘는ë°, ìŒì„±ì¸ì‹ê³¼ ìŒì„±í•©ì„±ìœ¼ë¡œ 나뉜다.

Speech Applications

- ìŒì„±ì¸ì‹ (Speech-To-Text, STT, ASR - automatic speech recognition)

- ìŒì„±í•©ì„± (Text-to-Speech, TTS)

- ì‘ìš© 예시 : ì•„ì´í° siri (ìŒì„±ë¹„ì„œ), 스마트 스피커, ìžë™ 회ì˜ë¡ 작성, ë™ì˜ìƒ ìžë™ìžë§‰, ë™ì‹œí†µë²ˆì—, í™”ìžì¸ì‹(í™”ìžê°€ 누구ì¸ì§€ ì‹ë³„), ìŒì„±ì¸ì‹ 주문/예약 등..

Speech Data

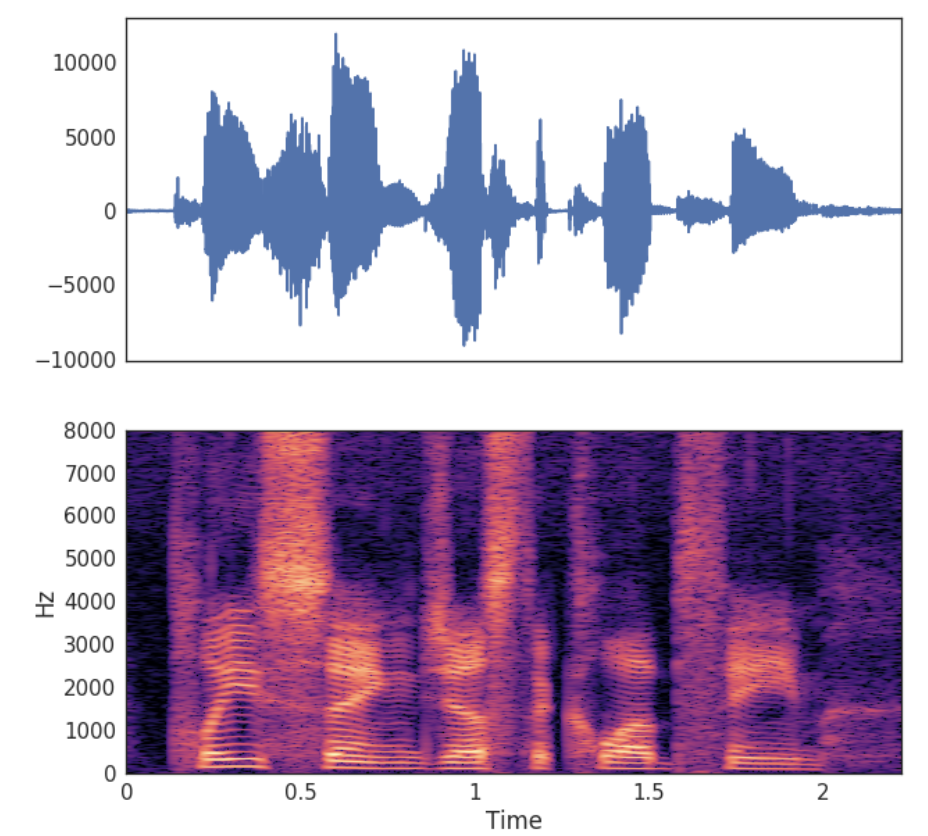

- ìŒì„± 파형 (Waveform) - ìŒì„± 파ì¼

- 스펙트로그램 (Spectrogram)

- Utterance (사용ìžì˜ ë§ / Text) - 발화 í…스트

- (Optional) Alignment ì •ë ¬ - 어디서 부터 어디까지가 í…스트 ì–´ëŠ ë¶€ë¶„ê¹Œì§€ 해당ë˜ëŠ”지

ìŒì„± 파형 (Waveform)

ìŒì„± ë°ì´í„°ëŠ” Waveform 파ì¼ë¡œ ì €ìž¥ì´ ëœë‹¤. Waveformì€ ì„¸ê¸° 표현ì´ë¼ê³ ë„ í• ìˆ˜ 있는ë°, 16,000 Hz ë¡œ ë…¹ìŒëœ ìŒì„±ì´ë¼ê³ 하면 1/16,000 ì´ˆ 마다 들어온 소리가 ì–´ëŠì •ë„ì˜ ì„¸ê¸°ë¥¼ ê°€ì§€ê³ ìžˆëŠ”ì§€ 기ë¡í•œ ê²ƒì´ Waveformì´ë‹¤. í—¤ë¥´ì¸ (Hertz, 기호: ãŽ)ì—ì„œ 1 Hz는 1ì´ˆì— í•œ ë²ˆì„ ì˜ë¯¸í•œë‹¤. 즉 100 Hz는 1ì´ˆì— 100ë²ˆì„ ë°˜ë³µ í˜¹ì€ ì§„ë™í•œë‹¤. ìŒì„±ì„ í—¤ë¥´ì¸ ë‹¨ìœ„ì˜ ì£¼íŒŒìˆ˜(frequency)ë¡œ ê´€ì¸¡í• ìˆ˜ ìžˆê³ , 우리가 ë“¤ì„ ìˆ˜ 있는 ëª¨ë“ ì†Œë¦¬ëŠ” 다양한 주파수 ì„±ë¶„ë“¤ì˜ í•©ìœ¼ë¡œ ì´ë£¨ì–´ì ¸ 있다 (주파수가 높ì„ìˆ˜ë¡ ìŒì´ 높게 들림).

Waveform í˜•íƒœì˜ ë°ì´í„°ëŠ” ì „ì²˜ë¦¬ë¥¼ 통해서 ìœ ì˜ë¯¸í•œ ì •ë³´ë¥¼ ê°€ì§€ê³ ìžˆëŠ” ì–´ë–¤ 형태로 ë§Œë“ ë‹¤. Waveformì€ í‘¸ë¦¬ì— ë³€í™˜(Fourier transform, FT)ì„ ê±°ì³ì„œ Spectrogramì´ë¼ëŠ” 피ì³ë¡œ 바꿀 수 있다. ì´ë ‡ê²Œ ìŒì„± íŒŒí˜•ì„ ë³€í™˜í•˜ëŠ” ì´ìœ 는 ìŒì„±ì— 들어있는 ì •ë³´ (ë°œìŒì˜ 종류, 성별, ìŒìƒ‰, ë†’ì´ ë“±)ì„ ìŒì„± ì‹ í˜¸/파형ì—ì„œ 바로 얻어낼 수 ì—†ê³ ìˆ˜í•™ì ì¸ ì‹ í˜¸ì²˜ë¦¬ë¥¼ ê±°ì³ì„œ ì¶”ì¶œí• ìˆ˜ 있기 때문ì´ë‹¤. ê·¸ 중 í‘¸ë¦¬ì— ë³€í™˜ì´ë¼ëŠ” 함수를 사용해서 íŠ¹ì • 시간 길ì´ì˜ ìŒì„± ì¡°ê°(í”„ë ˆìž„ì´ë¼ê³ 함)ì´ ê°ê°ì˜ 주파수 ì„±ë¶„ë“¤ì„ ì–¼ë§ˆë§Œí¼ ê°–ê³ ìžˆëŠ”ì§€ë¥¼ ì˜ë¯¸í•˜ëŠ” 스펙트럼(Spectrum)ì„ ì–»ì„ ìˆ˜ 있다. ìŒì„± ì „ì²´ë¡œë¶€í„° ì–»ì€ ì—¬ëŸ¬ê°œì˜ ìŠ¤íŽ™íŠ¸ëŸ¼ì„ ì‹œê°„ ì¶•ì— ë‚˜ì—´í•˜ë©´ 시간 ë³€í™”ì— ë”°ë¥¸ ìŠ¤íŽ™íŠ¸ëŸ¼ì˜ ë³€í™”ì¸ ìŠ¤íŽ™íŠ¸ë¡œê·¸ëž¨(Spectrogram)ì„ ì–»ê²Œ ëœë‹¤.

ì°¸ê³ : tech.kakaoenterprise.com/66

Traditional Speech To Text -> End-to-End Deep Learning

ì „í†µì ì¸ STTì—서는 Feature Extraction (í‘¸ë¦¬ì— ë³€í™˜)ì„ ê±°ì¹˜ê³ , Acoustic Model + Lexicon + Language Modelì„ í•©ì³ Decoderë¡œ 만들어 아래 사진처럼 ê°ê°ì˜ ê³¼ì •ì„ ê±°ì³ ì¡°í•©í•˜ëŠ” ê³¼ì •ì´ì—ˆë‹¤ë©´ 2010년대 초반 딥러ë‹ì´ 나와 ì´ ëª¨ë“ ê²ƒì„ í•˜ë‚˜ë¡œ í• ìˆ˜ 있다 = ê°ê°ì˜ ê³¼ì •ì´ ê°œë³„ì 으로 í•„ìš” 없다는 ê°œë…ì´ ë“±ìž¥í•´ End-to-End (E2E) ë¼ê³ 부르기 ì‹œìž‘í–ˆë‹¤ê³ í•œë‹¤.

* 알아ë‘ë©´ ì¢‹ì€ ë” deepí•œ ê°œë… ðŸ‘‡

<ì „í†µì ì¸ ìŒì„±ì¸ì‹ê³¼ 딥러ë‹>

ìŒì„±ì¸ì‹ì—ì„œ 최근 ì£¼ëª©ë°›ê³ ìžˆëŠ” 딥러ë‹(deep learning)ì€ ìžë£Œ(ìž…ë ¥)ì—ì„œ 목표한 ê²°ê³¼(ì¶œë ¥)ì„ ë³„ë„ì˜ ì¤‘ê°„ 매개 ì—†ì´ í•™ìŠµí•˜ëŠ” end-to-end í•™ìŠµì„ ê°€ëŠ¥ì¼€ 했다. E2E í•™ìŠµì„ ì´ìš©í•œ ìŒì„±ì¸ì‹ì—서는 주어진 ìŒì„±ì„ ìŒì†Œ ë° í˜•íƒœì†Œë¥¼ 거치지 ì•Šê³ ë°”ë¡œ 단어나 문장으로 ë³€í™˜í• ìˆ˜ 있다. ìŒì„±ì¸ì‹ì˜ 여러 중간 ë‹¨ê³„ë“¤ì„ ìƒëžµí•˜ë©´ ìŒì†Œ 단위로 í›ˆë ¨ì„ í• í•„ìš” ì—†ê³ , ìŒì†Œë¥¼ 매개로 하는 중간 단계와 ë ‰ì‹œì½˜ ì‚¬ì „ì´ ìƒëžµí• 수 있어 ê³¼ì •ì´ ê°„ì†Œí™”ëœë‹¤.

대표ì ì¸ ìŒì„±ì¸ì‹ì˜ E2E 모형으로는 Graves 등 (2006)ì´ ì œì•ˆí•œ 연결성 시계열 분류기(connectionist temporal classification; CTC) 모형과 Chan 등 (2015)ê°€ ì œì•ˆí•œ listen, attend, and spell (LAS) ëª¨í˜•ì´ ìžˆë‹¤.

<디코ë”란? + ë¹” íƒìƒ‰ + 언어 모형>

딥러ë‹ì„ 기반으로 í•œ ìŒì„± ì¸ì‹ ëª¨í˜•ì€ ìŒì„± ìžë£Œë¥¼ ìž ìž¬ 변수로 변환하는 ì¸ì½”ë”(encoder)와 ìž ìž¬ 변수로부터 문ìžì—´ì„ 얻어내는 디코ë”(decoder)ë¡œ 구성ë˜ì–´ 있다.

ì¼ë°˜ì 으로 ë””ì½”ë”©ì„ í• ë•ŒëŠ” ëª¨ë“ ë¬¸ìžì—´ì´ 가지는 í™•ë¥ ì„ ê³„ì‚°í•´ 가장 ë†’ì€ í™•ë¥ ì„ ì§€ë‹Œ 문ìžì—´ì„ 찾는 ë°©ì‹ìœ¼ë¡œ 한다 (yˆ = argmax(p(y|x, θ))). 그러나 시간ì´ë‚˜ 문ìžì—´ì˜ 길ì´ì— ë”°ë¼ì„œ 가능한 문ìžì˜ 개수가 지수ì 으로 ì¦ê°€í•˜ë¯€ë¡œ 비효율ì ì´ë‹¤. ë”°ë¼ì„œ ëª¨ë“ ê°€ëŠ¥í•œ 문ìžì—´ì„ íƒìƒ‰í•˜ëŠ” ëŒ€ì‹ ë¹” íƒìƒ‰(beam search)ì„ ì´ìš©í•˜ì—¬ 기억해야 하는 노드를 ì œí•œí•˜ëŠ” ê¸°ë²•ì„ ì‚¬ìš©í•˜ì˜€ë‹¤. ë¹” íƒìƒ‰ì€ 주어진 ë¬¸ìž ë‹¤ìŒì— ì„ íƒë 수 있는 문ìžì˜ ëª¨ë“ ê°€ëŠ¥í•œ ê²½ìš°ì˜ ìˆ˜ë¥¼ 계산한 후, 미리 ì •í•œ ìƒìœ„ Bê°œ í™•ë¥ ì˜ ë¬¸ìž ì¡°í•©ë§Œì„ ì·¨í•˜ì—¬ 목표 문ìžì—´ë¥¼ ì°¾ì„때까지 반복하는 경험ì íƒìƒ‰ ì•Œê³ ë¦¬ë“¬ì´ë‹¤. 여기서, B는 빔너비(beam width)ë¼ê³ 부른다.

추가로 디코딩 ì‹œì— ë”°ë¡œ í›ˆë ¨ëœ ì–¸ì–´ ëª¨í˜•ì„ ì´ìš©í•˜ì—¬ ì •í™•ë„를 ë†’ì¼ ìˆ˜ 있다. ì¼ë°˜ì 으로 ìŒì„±ì¸ì‹ ëª¨í˜•ì— ìž…ë ¥ìœ¼ë¡œ 들어오는 ìŒì„±ì€ 아무 ì˜ë¯¸ 없는 ë°œìŒë“¤ì´ ì•„ë‹ˆë¼ ì–¸ì–´ì 맥ë½ì´ë‚˜ 문법과 ê°™ì´ ìŒì„±ê³¼ ë…립ì ì¸ ì–¸ì–´ì íŠ¹ì„±ì´ ì¡´ìž¬í•˜ëŠ” 문장ì´ë‹¤. ë”°ë¼ì„œ, ì´ëŸ¬í•œ ì •ë³´ë¥¼ ë”°ë¡œ 학습한 ë’¤ì— ëª¨í˜•ì— ì¶”ê°€í•˜ì—¬ ì¸ì‹ì˜ ì •í™•ë„를 ë†’ì¼ ìˆ˜ 있다.

ì°¸ê³ : Korean speech recognition using deep learning (2019) http://www.kss.or.kr/jounalDown.php?IDX=4245

E2Eë¡œ í›ˆë ¨ë˜ë”ë¼ë„ ì•„ì§ í•„ìš”í•œ 것들

- Feature Extraction ê³¼ì • - 스펙트로그램 (Spectrogram)ì„ ë½‘ì•„ë‚´ëŠ” í‘¸ë¦¬ì— ë³€í™˜ ê³¼ì •

- Beam search decoder

- Language model - (Beam search)ì— í•„ìš”

- 모ë¸ì˜ 학습과 별개로 ìŒì„± ìžë£Œë¥¼ 문ìžì—´ë¡œ 바꾸는 ë””ì½”ë”©ì— ì´ìš©ë˜ëŠ” ë¹” íƒìƒ‰(beam search) ë° ì–¸ì–´ 모형(language model) => ìœ„ì— "* 알아ë‘ë©´ ì¢‹ì€ ë” deepí•œ ê°œë… ðŸ‘‡" ì°¸ê³

ëª¨ë¸ 1. Acoustic Model (Deep Speech 2)

2015ë…„ì— ë‚˜ì˜¨ Deep Speech 2 논문 (ì¤‘êµ ëŒ€í‘œ IT 기업 ‘ë°”ì´ë‘(baidu)’ì—ì„œ 공개한 End-to-End ìŒì„± ì¸ì‹ 모ë¸)

Input으로 Spectrogramì„ ë°›ê³ Output으로 CTC(connectionist temporal classification) 반환하는 ê²ƒì„ ë³¼ 수 있다. ì´ ëª¨ë¸ì—ì„œ 살펴ë´ì•¼í• ì ì€ ì•„ëž˜ì™€ 같다.

- ìŒì„± ì¸ì‹ì— ìœ ë¦¬í•œ ëª¨ë¸ ì•„í‚¤í…처

- 효율ì ì¸ í•™ìŠµ í…Œí¬ë‹‰ : Connectionist Temporal Classification(CTC) loss ì§ì ‘ 구현 등

ìž…ë ¥ë°›ì€ Spectrogramì—ì„œ 중요한 특징 (feature) ì„ ë½‘ì•„ë‚´ëŠ” ë ˆì´ì–´ë¡œ Convolutional Neural Network를 사용한다. ì´í›„ ì–‘ë°©í–¥(bidirectional) Recurrent Neural Network를 ë‘ê³ , 마지막ì—는 Fully Connected Layerê°€ 있다.

ì°¸ê³ : ratsgo.github.io/speechbook/docs/neuralam/deepspeech

CTC : Connectionist Temporal Classification (연결성 시계열 분류기)

핵심 ì•„ì´ë””어는 ìŒì„±ì˜ 길ì´ì— 맞게 í…ìŠ¤íŠ¸ì˜ ê¸¸ì´ë¥¼ 늘린다는 ê°œë…ì´ë‹¤. ìŒì„±ì˜ 길ì´(S)ê°€ 7, í…스트(T)ê°€ 3ì´ë¼ë©´ 모ìžëž€ ë§Œí¼ Blank ("_")ë¡œ 채운다. 하지만 우리는 어디서 Blankê°€ ë“¤ì–´ê°€ê³ ì–´ë””ì„œ ì‹¤ì œ Textê°€ 들어가야ë˜ëŠ”지 알지 못한다. 그럼으로 가능한 ëª¨ë“ ì¡°í•©ì˜ í•©ìœ¼ë¡œ í™•ë¥ ì„ í‘œì‹œí•œë‹¤. CTC는 최ì ì˜ ì •ë ¬(Alignment)를 찾아내기 위해 가능한 ëª¨ë“ ì‹œí€€ìŠ¤ë“¤ì„ ë‚˜ì—´í•œë‹¤.

CTC는 현재 다ì´ë‹¤ë¯¹ 프로그래ë°ì„ 통해 ì—°ì‚°ì†ë„ë„ ê·¹ì 으로 빨ë¼ì ¸ 있으며, PyTorch, TensorFlowì— ê¸°ë³¸ìœ¼ë¡œ ë‚´ìž¥ì´ ë˜ìžˆì–´ 사용하기 쉽다. CTCì˜ ìž¥ì ì€ Encoder만 ìŒ“ê³ , ê·¸ ìœ„ì— CTC Loss만 넣으면 ìŒì„±ì¸ì‹ì´ 가능하다는 ì ì´ë‹¤. ë˜í•œ ì–´ëŠì •ë„ ì •ë ¬ 위치를 ì¶”ì¶œí• ìˆ˜ 있다 (Probability, Distributionì„ ë³´ê³ ì–´ëŠì •ë„ ì •ë ¬ 위치를 ì—ì‚°í• ìˆ˜ 있다 - ì •í™•í•˜ì§„ ì•ŠìŒ). 단ì ì€ ì¶”ê°€ì ì¸ LM decoding (Beam Search Decoding)ì´ ì—†ìœ¼ë©´ ì„±ëŠ¥ì´ ê·¹ì 으로 좋아지지 않는다.

* 알아ë‘ë©´ ì¢‹ì€ ë” deepí•œ ê°œë… ðŸ‘‡

from : m.blog.naver.com/PostView.nhn?blogId=sogangori&logNo=221183469708&proxyReferer=https:%2F%2Fwww.google.com%2F'

CTC 네트워í¬ëŠ” softmax output layer 를 갖는다. 소프트맥스는 í´ëž˜ìŠ¤ 갯수 Lê°œ 보다 하나 ë§Žì€ L + 1 ê°œì˜ ì•¡í‹°ë² ì´ì…˜ì„ 갖는다. 추가 1 ì€'blank' í˜¹ì€ no label ì˜ í™•ë¥ ì´ë‹¤. ì–´ëŠ í•˜ë‚˜ì˜ ë¼ë²¨ì‹œí€€ìŠ¤ {DOG} ì— ëŒ€í•œ 네트워í¬ì˜ ouputì€ {-D-OOGG} í˜¹ì€ {-DD-OGG-} 등으로 다양하게 ë‚˜íƒ€ë‚ ìˆ˜ 있다. (-: blank label ,공백)

예를 들어 네트워í¬ì˜ ì¶œë ¥ì˜ max 채ë„ê°’ì´ {0.5, 0.55, 0.6, 0.65, 0.7, 0.75, 0.8} ì´ê³ 해당 채ë„ì€ {-D-OOGG} ì˜€ë‹¤ê³ í•˜ìž. 첫번째 ìžë¦¬ê°€ - ì¼ í™•ë¥ ì´ 0.5 , ë‘번째 ìžë¦¬ê°€ D ì¼ í™•ë¥ ì´ 0.55 ë¼ê³ í•´ì„ëœë‹¤. ì´ ë„¤íŠ¸ì›Œí¬ì˜ ì¶œë ¥ì´ paths ì¸ë° ì´ paths ì˜ ëª¨ë“ í™•ë¥ ì„ ì „ë¶€ 곱한 ê²ƒì´ paths ì˜ í™•ë¥ ì´ë‹¤.

0.5*0.55*0.6*0.65*0.7*0.75*0.8 ~= 0.01 보다 ìž‘ê² ë‹¤.

다ìŒìœ¼ë¡œëŠ” many-to-one mapì¸ B 함수가 필요하다. í•œ ë¼ë²¨ì— 대해서 paths 는 {-D-OOGG},{-DD-OGG-} 처럼 다양하게 ë‚˜íƒ€ë‚ ìˆ˜ 있다. B 함수는 paths ì˜ ë¹ˆì¹¸ê³¼ ì¤‘ë³µì„ ì œê±°í•œë‹¤.

예) B(paths) = ë¼ë²¨ì‹œí€€ìŠ¤

B(ab) = B(aab) = B(abb) = B(-ab) = B(a-b) = B(ab-)= ab

B(-D-OOGG) = B(-DD-OGG-) = DOG

í•œ ë¼ë²¨ì˜ paths 는 다양하게 ë‚˜íƒ€ë‚ ìˆ˜ ìžˆëŠ”ë° ë¼ë²¨ì— 대한 Bì˜ ì—함수를 통해 ëª¨ë“ ê°€ëŠ¥í•œ paths 를 ì–»ì„ ìˆ˜ 있다. ëª¨ë“ ê°€ëŠ¥í•œ paths ë“¤ì˜ í™•ë¥ ë“¤(pathsì˜ ëª¨ë“ ìš”ì†Œì˜ í™•ë¥ ë“¤ì„ ì „ë¶€ 곱한것)ì„ ëª¨ë‘ ë”í•œê²ƒì´ xê°€ 주어졌ì„ë•Œ ë¼ë²¨ì˜ 조건부 í™•ë¥ ì´ë‹¤.

=> ì´ ëª¨ë“ ê°€ëŠ¥í•œ ë¼ë²¨ì˜ ì´í™•ë¥ ì„ ë†’ì´ëŠ” ê²ƒì´ í•™ìŠµì˜ ëª©í‘œì´ë‹¤.

주어진 x 로부터 분류를 가장 ì ì ˆí•˜ê²Œ 해야 하므로 p(L|x) ê°€ 가장 í° path 를 ì„ íƒí•´ì•¼ 한다. íƒìƒ‰ì„ 하면서 ì ì ˆí•œ ë¼ë²¨ë§ì„ 찾는다 => CTCì˜ ë‹¨ì ê³¼ ì—°ê²° (단ì ì€ ì¶”ê°€ì ì¸ LM decoding (Beam Search Decoding)ì´ ì—†ìœ¼ë©´ ì„±ëŠ¥ì´ ê·¹ì 으로 좋아지지 않는다.)

ëª¨ë¸ 2. LAS: Listen, Attend, Spell

Deep Speech2와 비슷한 ì‹œê¸°ì— Google Brainì—ì„œ ì œì•ˆí•œ Listen, Attend and Spell(LAS) 모ë¸ì´ë‹¤. Listener, Attention, ê·¸ë¦¬ê³ Spellerë¡œ ë‚˜ëˆ ì§€ëŠ” ë¶€ë¶„ì— ì£¼ëª©í•´ì„œ 살펴보면 ëœë‹¤. CTC, RNN-T와 달리 Attention ì•Œê³ ë¦¬ì¦˜ì„ ì´ìš©í•˜ì—¬ ìŒí–¥ ìž…ë ¥ê³¼ ë ˆì´ë¸” ì¶œë ¥ 사ì´ì˜ ì •ë ¬(Alignment)ì„ ê³„ì‚°í•œë‹¤.

Listener는 피ë¼ë¯¸ë“œ 형ì‹ìœ¼ë¡œ êµ¬ëœ bidirectional LSTM(BLSTM) ì¸ì½”ë”ì´ë©° ìž…ë ¥ 시퀀스 x로부터 íŠ¹ì§•ì„ ë½‘ì•„ë‚¸ë‹¤. Listener는 BLSTMì„ Pyramidal 형ì‹ìœ¼ë¡œ 3개를 붙여서 ì‚¬ìš©í•˜ê³ ìžˆë‹¤. 논문ì—서는 ì´ë¥¼ pBLSTM으로 ë¶€ë¥´ê³ ìžˆìœ¼ë©°, pyramidal 하게 사용하는 ì´ìœ 는 pBLSTM 1개당 ì—°ì‚°ì†ë„를 2ë°°ë¡œ 줄여주기 때문ì´ë‹¤. 3ê°œì˜ BLSTMì˜ top of the bottomì— ìŒ“ì€ pBLSTMì€ time resolutionì„ 2ì˜ 3승만í¼, 즉 8 ë°°ë§Œí¼ ì¤„ì—¬ì¤€ë‹¤ê³ í•œë‹¤.

Speller는 attentionì„ ì‚¬ìš©í•´ì„œ ì¶œë ¥ì„ í•˜ëŠ” ë””ì½”ë” decoderì´ë‹¤. AttendAndSpell 함수는 attention ê¸°ë°˜ì˜ LSTM ë³€í™˜ê¸°ì¸ decoder를 통해서 계산ëœë‹¤. decoder는 매 time step마다 ì´ì „ì— ê²°ì •ëœ ë¬¸ìžë“¤ì— 대한 ë‹¤ìŒ ë¬¸ìžì˜ 분í¬ë¥¼ ìƒì„±í•œë‹¤. (ëª¨ë“ ì¶œë ¥ 단계ì—ì„œ 변환기는 ì´ì „ì— ë³¸ ëª¨ë“ ë¬¸ìžë¥¼ 조건으로 í•œ ë‹¤ìŒ ë¬¸ìžì— 대한 í™•ë¥ ë¶„í¬ë¥¼ ìƒì„±í•œë‹¤)

ì´ ëª¨ë¸ì˜ 학습ì€, ìž…ë ¥ ìŒì„±ì— 대해 알맞는 sequenceì˜ log probability를 maximize한다. ê·¸ë¦¬ê³ ë””ì½”ë”© ê´€ë ¨í•˜ì—¬, test ì‹œì— ê°€ìž¥ ê·¼ì ‘í•œ character sequence를 주어진 ìŒí–¥ì— 대해 찾는다.

Content based Attention Mechanismì€ ë¬¸ìžì™€ 오디오 ì‹ í˜¸ 사ì´ì˜ 명확한 ì •ë ¬ì„ ë§Œë“ ë‹¤. 아래 사진ì—ì„œ 오른쪽 ì•„ëž˜ì— ìžˆëŠ” 그리드는 문ìžì™€ ìž…ë ¥ ìŒì„±ê°„ì˜ í• ë‹¹ (Alignment / ì •ë ¬)ì„ ë³´ì—¬ì¤€ë‹¤. "how much would a woodchuck chuck" ë¼ëŠ” ìŒì„± inputì— ë”°ë¥¸ character alignmentì¸ë°, Content based attention mechanismì€ ì²« 번째 문ìžì— 대한 오디오 ì‹œí€€ìŠ¤ì˜ ì‹œìž‘ 위치를 올바르게 ì‹ë³„í• ìˆ˜ ìžˆì—ˆë‹¤ê³ í•œë‹¤. => ì–´ë–¤ í…스트를 만들 ë•Œ 어디를 ë´ì•¼ 하나

ì°¸ê³ : jybaek.tistory.com/793

www.secmem.org/blog/2019/07/21/Listen,-Attend-and-Spell/

ëª¨ë¸ 3. RNN-T: Recurrent Neural Network Transducer

CTC와 ìœ ì‚¬í•˜ë‹¤. CTC와 마찬가지로 최ì ì˜ ì •ë ¬(Alignment)ì„ ì°¾ì•„ë‚´ê¸° 위해 ëª¨ë“ ì‹œí€€ìŠ¤ë¥¼ 나열한 후 구한다. 하지만 CTC와 달리 조건부 ë…ë¦½ì„ ê°€ì •í•˜ì§€ 않기 ë•Œë¬¸ì— ìµœì 경로 ê³„ì‚°ì´ CTC와는 다르며, CTC보다 ë” ë³µìž¡í•˜ê²Œ 계산ëœë‹¤ê³ 한다. CTCì—ì„ ë‹¤ìŒ ë¼ë²¨ì´ 나올 ë•Œ 까지 ìœ ì§€ê°€ ëœë‹¤. "나는 í•™êµë¥¼ 간다"ë¼ê³ ë¬¸ìž¥ì„ ì˜ˆì¸¡í•œë‹¤ê³ í•˜ë©´ ë‚˜ëŠ”ì„ ì˜ˆì¸¡ í›„ì— í•™êµì— ë¼ëŠ” ìŒì„±ì´ 들어가면 í•™êµë¥¼ 예측한다. Alignment ë°ì´í„°ê°€ 필요없다. ìŒì„± í”„ë ˆìž„ì´ ë„˜ì–´ê°€ëŠ” 매 순간마다 지금 단어 (ë¼ë²¨)를 ìœ ì§€í• ì§€, ë‹¤ìŒ ë‹¨ì–´ë¡œ ì§„í–‰í• ì§€ 찾아낸다. CTC와 마찬가지로 가능한 ëª¨ë“ ê²½ë¡œ, pathì˜ ì¡°í•©ìœ¼ë¡œ í™•ë¥ ì„ ê³„ì‚°í•˜ê³ , ê·¸ í™•ë¥ ì„ ë†’ì´ëŠ” 방향으로 í›ˆë ¨ì„ í•œë‹¤. 아래는 기존 CTC 모ë¸ê³¼ì˜ ì°¨ì´ë¥¼ 보여주는 그림ì¸ë°, RNN-T는 Encoderì— Prediction Network를 ì—°ê²°í•´ì„œ 사용한다. prediction network를 ì—°ê²°ì‹œì¼œì¤Œìœ¼ë¡œì¨ í›„ì²˜ë¦¬ 언어모ë¸ì˜ 효과를 ì–»ì„ ìˆ˜ ìžˆë‹¤ê³ í•œë‹¤.

ìµœê·¼ì˜ ëª¨ë¸ë“¤ì€ LAS, RNN-T 중 하나로 주로 í›ˆë ¨ì„ í•œë‹¤ê³ í•œë‹¤. RNN-Tê°€ ë” ê°ê´‘ 받는 추세ì´ë‹¤ (다ìŒì‹œê°„ì— Streamingê³¼ ê´€ë ¨).

ì°¸ê³ : jybaek.tistory.com/793

ëª¨ë¸ ìš”ì•½

요약 : n to m 갯수를 맞춰ë¼! (ìŒì„±ì˜ 길ì´ì— 맞게 í…ìŠ¤íŠ¸ì˜ ê¸¸ì´) 어떻게?

SOTA (State Of The Art) in ASR

Summary

=> Speech 는 ë°ì´í„°ê°€ ì—„ì²ë‚œ ì˜í–¥ì„ 준다. (학습 안한 ë…¸ì´ì¦ˆê°€ ì„žì´ë©´ 못맞출 ê°€ëŠ¥ì„±ì´ ë†’ë‹¤)

=> ëŒ€ë¶€ë¶„ì˜ ëª¨ë¸ì€ ì´ë¯¸ ì—„ì²ë‚œ ì„±ëŠ¥ì„ ë³´ì—¬ì¤€ë‹¤. ==.. ìƒìš© ìŒì„± API를 ì“°ë©´ ì„±ëŠ¥ì´ ìž˜ë‚˜ì˜¨ë‹¤.

=> 가지는 ë°ì´í„°ê°€ 특수하다면 (noisy), ë˜ëŠ” í™˜ê²½ì— ë§žëŠ” í›ˆë ¨ì´ í•„ìš”í•˜ë‹¤ë©´ ë¼ì´ë¸ŒëŸ¬ë¦¬ë¥¼ 사용하면 ëœë‹¤

=> ë˜ëŠ” ì‚¬ì „ì— í›ˆë ¨ëœ ìŒì„± ì¸ì‹ 모ë¸ì„ 사용하면 ëœë‹¤ (ìŒì„±ì¸ì‹ë„ ì´ì œ pre-training, fine-tuning... ì˜ì–´ë¡œ ì‚¬ì „í•™ìŠµ ë˜ìžˆì–´ë„ ì‚¬ëžŒì˜ ë°œìŒê¸°í˜¸ê°€ 비슷해서 다른 언어로 ë°”ê¿¨ì„ ë•Œë„ ìž˜ëœë‹¤?).

=> 가장 대표ì ì¸ ê²ƒì´ Wav2Vec ëª¨ë¸ (다ìŒì‹œê°„ì—...)

=> HuggingFace 를 ì“°ìž...

'AI > Self-Study' ì¹´í…Œê³ ë¦¬ì˜ ë‹¤ë¥¸ 글

댓글

ì´ ê¸€ ê³µìœ í•˜ê¸°

-

구ë…하기

구ë…하기

-

카카오톡

카카오톡

-

ë¼ì¸

ë¼ì¸

-

트위터

트위터

-

Facebook

Facebook

-

ì¹´ì¹´ì˜¤ìŠ¤í† ë¦¬

ì¹´ì¹´ì˜¤ìŠ¤í† ë¦¬

-

밴드

밴드

-

네ì´ë²„ 블로그

네ì´ë²„ 블로그

-

Pocket

Pocket

-

Evernote

Evernote

다른 글

-

yolov5 학습 íŠœí† ë¦¬ì–¼ 1

yolov5 학습 íŠœí† ë¦¬ì–¼ 1

2021.05.11 -

한줄로 Train/Test/Validation 나누기 (splitfolders : annotationë„ í•¨ê»˜ 나누는법)

한줄로 Train/Test/Validation 나누기 (splitfolders : annotationë„ í•¨ê»˜ 나누는법)

2021.05.11 -

Keras : ImageDataGenerator ëŒ€ì‹ ì— tf.dataë¡œ ë¹ ë¥´ê²Œ 학습하기 2

Keras : ImageDataGenerator ëŒ€ì‹ ì— tf.dataë¡œ ë¹ ë¥´ê²Œ 학습하기 2

2021.04.12 -

Keras : ImageDataGenerator ëŒ€ì‹ ì— tf.dataë¡œ ë¹ ë¥´ê²Œ 학습하기 1

Keras : ImageDataGenerator ëŒ€ì‹ ì— tf.dataë¡œ ë¹ ë¥´ê²Œ 학습하기 1

2021.04.12